awesome-diffusion-model-in-rl

扩散模型在强化学习领域的最新研究进展汇总

本项目汇总了强化学习领域应用扩散模型的最新研究论文,涵盖离线RL、机器人控制、轨迹规划等多个方向。持续追踪并整理扩散强化学习的前沿进展,为研究人员提供全面的参考资源。每篇论文均附有概述、代码链接和实验环境等详细信息,方便读者深入了解。

RL中的扩散模型精选

这是一个关于RL中扩散模型研究论文的集合。 本仓库将持续更新以追踪扩散强化学习的前沿进展。

欢迎关注和点赞!

目录

RL中扩散模型概述

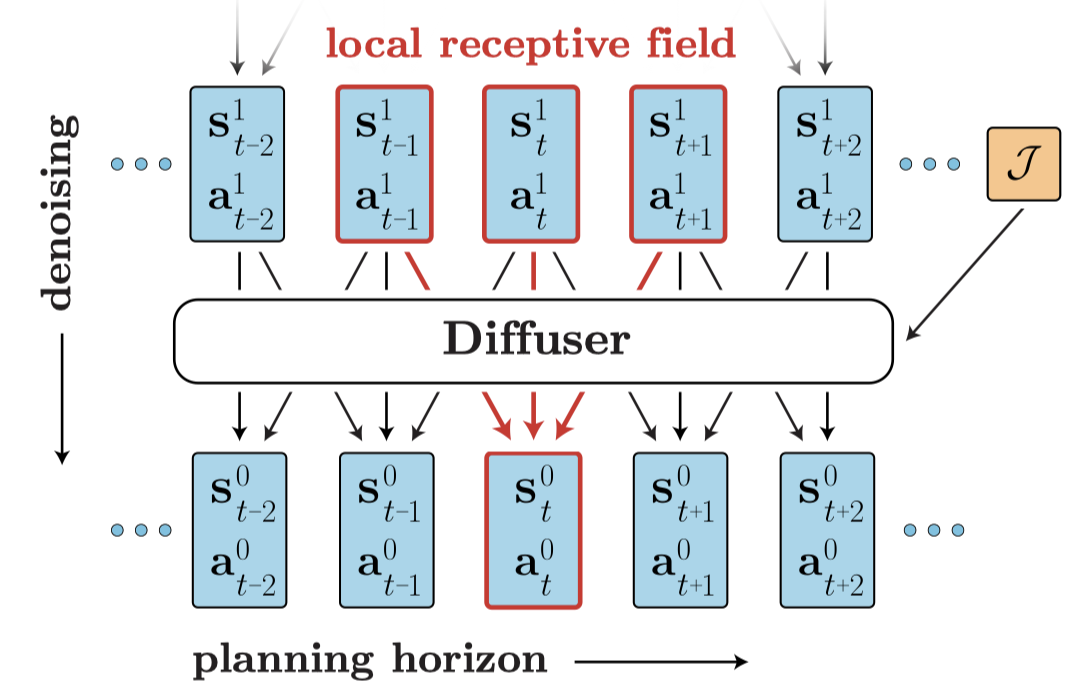

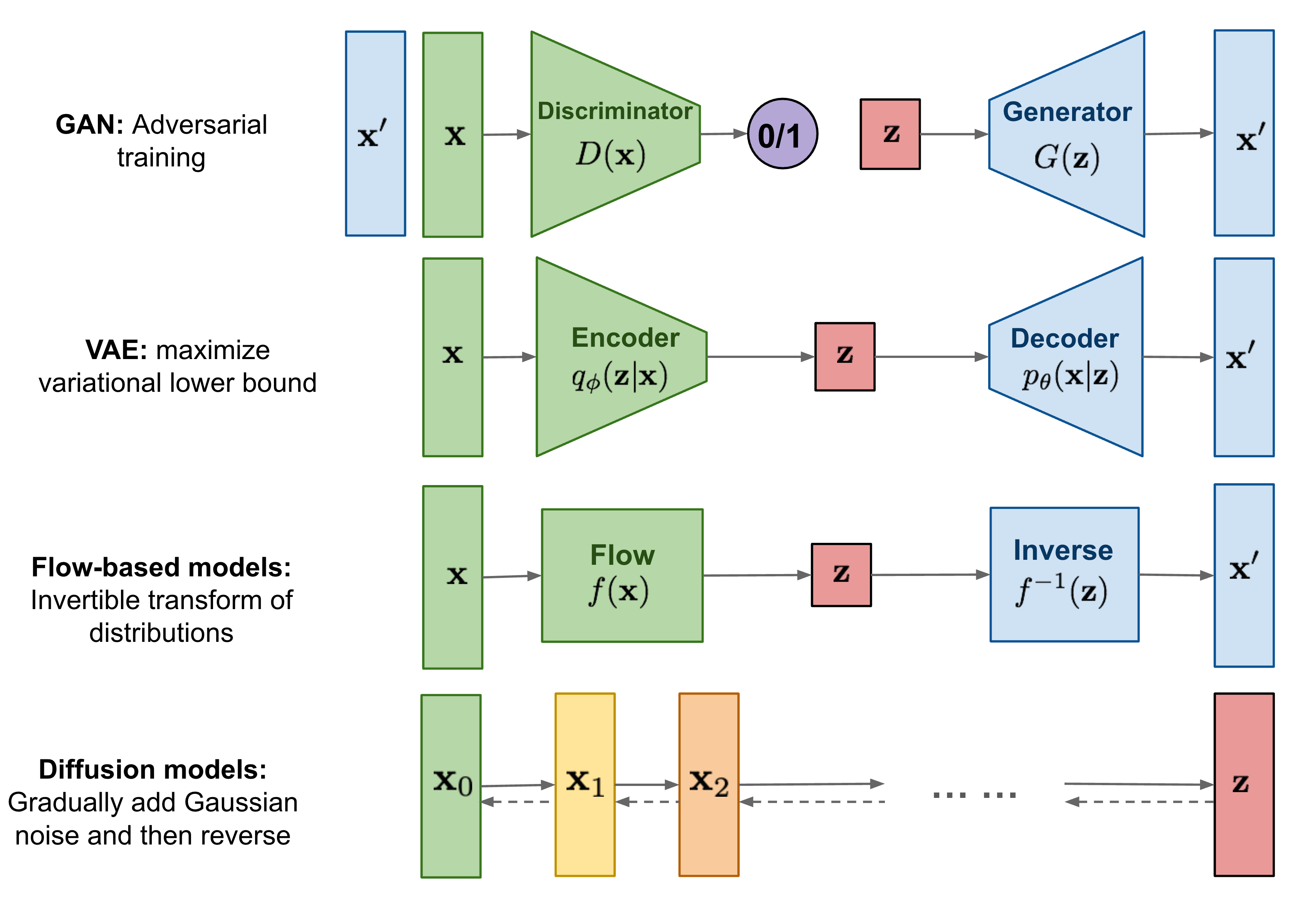

RL中的扩散模型由Janner、Michael等人在"使用扩散进行灵活行为合成的规划"中首次提出。它将轨迹优化视为一个扩散概率模型,通过迭代细化轨迹进行规划。

还有另一种方法:Wang, Z.等人在"扩散策略作为离线强化学习的表达性策略类"中提出将扩散模型作为离线RL中的策略优化。具体来说,Diffusion-QL从离线策略优化的角度将策略形成为以状态为条件的条件扩散模型。

优势

- 绕过了长期信用分配中的自举需求。

- 避免了由于折扣未来奖励而导致的不良短视行为。

- 享受语言和视觉领域广泛使用的扩散模型,这些模型易于扩展和适应多模态数据。

论文

格式:

- [标题](论文链接) [链接]

- 作者1、作者2和作者3...

- 发表方

- 关键词

- 代码

- 实验环境

Arxiv

-

3D扩散策略:通过简单的3D表示实现可泛化的视觉运动策略学习

- Yanjie Ze, Gu Zhang, Kangning Zhang, Chenyuan Hu, Muhan Wang, Huazhe Xu

- 关键词:3D扩散策略,视觉模仿学习

- 实验环境:MetaWorld, Adroit, DexArt

-

扩散演员-评论家:将约束策略迭代公式化为离线强化学习中的扩散噪声回归

- Linjiajie Fang, Ruoxue Liu, Jing Zhang, Wenjia Wang, Bing-Yi Jing

- 关键词:扩散模型,演员-评论家,离线RL

- 实验�环境:D4RL

-

- Ajay Sridhar, Dhruv Shah, Catherine Glossop, Sergey Levine

- 关键词:扩散模型,离线RL

- 实验环境:真实世界机器人操作

-

- Philippe Hansen-Estruch, Ilya Kostrikov, Michael Janner, Jakub Grudzien Kuba, Sergey Levine

- 关键词:扩散模型,离线RL

- 实验环境:D4RL

-

- Takuma Yoneda, Luzhe Sun, and Ge Yang, Bradly Stadie, Matthew Walter

- 关键词:扩散模型,模仿,机器人学

- 实验环境:2D控制、月球着陆器、月球探测器和方块推动

-

- Lili Chen, Shikhar Bahl, Deepak Pathak

- 关键词:扩散模型,模仿,机器人学

- 实验环境:CALVIN、Franka厨房、语言条件Ravens

-

- Mengda Xu, Zhenjia Xu, Cheng Chi, Manuela Veloso, Shuran Song

- 关键词:扩散模型,模仿,机器人学

- 实验环境:真实世界机器人操作

-

- Eley Ng, Ziang Liu, Monroe Kennedy III

- 关键词:扩散模型,人在环中,机器人学

- 实验环境:人在环中模拟

-

- Zoey Chen, Sho Kiami, Abhishek Gupta, Vikash Kumar

- 关键词:扩散模型、数据合成器、机器人学

- 实验环境:端到端视觉操作任务

-

- Tianhe Yu, Ted Xiao, Austin Stone, Jonathan Tompson, Anthony Brohan, Su Wang, Jaspiar Singh, Clayton Tan, Dee M, Jodilyn Peralta, Brian Ichter, Karol Hausman, Fei Xia

- 关键词:扩散模型、数据合成器、机器人学

- 实验环境:机器人操作任务

-

- Cong Lu, Philip J. Ball, Yee Whye Teh, Jack Parker-Holder

- 关键词:扩散模型、数据合成器

- 实验环境:D4RL

-

- Bogdan Mazoure, Walter Talbott, Miguel Angel Bautista, Devon Hjelm, Alexander Toshev, Josh Susskind

- 关键词:扩散模型、离策略学习、离线强化学习、强化学习、机器人学

- 实验环境:D4RL

-

- Yinan Zheng, Jianxiong Li, Dongjie Yu, Yujie Yang, Shengbo Eben Li, Xianyuan Zhan, Jingjing Liu

- 关键词:时间无关分类器引导、安全离线强化学习

- 代码:官方

- 实验环境:DSRL

-

- Marc Rigter, Jun Yamada, Ingmar Posner

- 关键词:世界模型、基于模型的强化学习、策略引导

- 实验环境:Gym MuJoCo

-

- Zhengbang Zhu, Hanye Zhao, Haoran He, Yichao Zhong, Shenyu Zhang, Yong Yu, Weinan Zhang

- 关键词:综述

-

- Yuhui Chen, Haoran Li, Dongbin Zhao

- 关键词:Q学习、样本效率、一致性策略

- 实验环境:DMC、Gym MuJoCo、D4RL

-

- Longxiang He, Linrui Zhang, Junbo Tan, Xueqian Wang

- 关键词:约束策略搜索、离线强化学习

- 实验环境:D4RL

-

- Vineet Jain, Siamak Ravanbakhsh

- 关键词:约束策略搜索、离线强化学习

- 实验环境:离线目标条件设置

-

AlignDiff:通过行为可定制扩散模型对齐多样化人类偏好

- Zibin Dong, Yifu Yuan, Jianye Hao, Fei Ni, Yao Mu, Yan Zheng, Yujing Hu, Tangjie Lv, Changjie Fan, Zhipeng Hu

- 关键词:RLHF、对齐、无分类器

- 实验环境:Gym MuJoCo

-

- Zihan Ding, Chi Jin

- 关键词:一致性策略、三种典型强化学习设置

- 实验环境:D4RL、Gym MuJoCo

-

- Zhengbang Zhu, Minghuan Liu, Liyuan Mao, Bingyi Kang, Minkai Xu, Yong Yu, Stefano Ermon, Weinan Zhang

- 关键词:多智能体、离线强化学习、无分类器

- 实验环境:MPE、SMAC、多智能体轨迹预测(MATP)

-

- Suzan Ece Ada, Erhan Oztop, Emre Ugur

- 关键词:离线强化学习、分布外泛化

- 实验环境:2D多模态上下文赌博机、D4RL

-

- Cheng Chi, Siyuan Feng, Yilun Du, Zhenjia Xu, Eric Cousineau, Benjamin Burchfiel, Shuran Song

- 关键词:机器人操作

- 实验环境:Robomimic、Push-T、多模态推块、Franka厨房

-

- Zhixuan Liang, Yao Mu, Mingyu Ding, Fei Ni, Masayoshi Tomizuka, Ping Luo

- 关键词:目标条件模仿学习、机器人学、无分类器

- 实验环境:CALVIN、Block-Push、Relay Kitchen

CVPR 2024

- 面向运动学感知多任务机器人操作的分层扩散策略

- Xiao Ma, Sumit Patidar, Iain Haughton, Stephen James

- 发表于: CVPR 2024

- 关键词: 长期任务规划, 扩散模型

- 代码: 官方

- 实验环境: RLBench

ICLR 2024

-

- Kevin Black, Michael Janner, Yilun Du, Ilya Kostrikov, Sergey Levine

- 发表于: ICLR 2024

- 关键词: 强化学习, RLHF, 扩散模型

- 代码: 官方

- 实验环境: 无

-

- Lunjun Zhang, Yuwen Xiong, Ze Yang, Sergio Casas, Rui Hu, Raquel Urtasun

- 发表于: ICLR 2024

- 关键词: 离散扩散; 世界模型; 自动驾驶

- 代码: 官方

- 实验环境: NuScenes, KITTI Odometry, Argoverse2 Lidar

NeurIPS 2023

-

- Haoran He, Chenjia Bai, Kang Xu, Zhuoran Yang, Weinan Zhang, Dong Wang, Bin Zhao, Xuelong Li

- 发表于: NeurIPS 2023

- 关键词: 多任务强化学习, 扩散模型, 规划, 数据合成

- 实验环境: D4RL

ICML 2023

-

- 范颖、李康旭

- 发表于:ICML 2023

- 关键词:基于强化学习的扩散模型训练、在线强化学习、采样优化

- 代码:官方

- 实验环境:CIFAR10、CelebA

-

MetaDiffuser:扩散模型作为离线元强化学习的条件规划器

- 倪飞、郝建烨、穆尧、袁一夫、郑岩�、王斌、梁志轩

- 发表于:ICML 2023

- 关键词:离线元强化学习、条件轨迹生成、泛化、分类器引导

- 实验环境:MuJoCo

ICLR 2023

-

- Tim Pearce、Tabish Rashid、Anssi Kanervisto、Dave Bignell、Mingfei Sun、Raluca Georgescu、Sergio Valcarcel Macua、Shan Zheng Tan、Ida Momennejad、Katja Hofmann、Sam Devlin

- 发表于:ICLR 2023

- 关键词:离线强化学习、策略优化、模仿学习、无分类器

- 实验环境:Claw、Kitchen、CSGO

ICRA 2023

- 用于可控交通模拟的引导条件扩散

- Ziyuan Zhong、Davis Rempe、Danfei Xu、Yuxiao Chen、Sushant Veer、Tong Che、Baishakhi Ray、Marco Pavone

- 发表于:ICRA 2023

- 关键词:交通模拟、多智能体、无分类器

- 实验环境:nuScenes

NeurIPS 2022

ICML 2022

贡献

我们的目标是使这个仓库变得更好。如果您有兴趣贡献,请参考这里的贡献指南。

许可证

强化学习中的优秀扩散模型在 Apache 2.0 许可下发布。

编辑推荐精选

扣子-AI办公

职场AI,就用扣子

AI办公助手,复杂任务高效处理。办公效率低?扣子空间AI助手支持播客生成、PPT制作、网页开发及报告写作,覆盖科研、商业、舆情等领域的专家Agent 7x24小时响应,生活工作无缝切换,提升50%效率!

堆友

多风格AI绘画神器

堆友平台由阿里巴巴设计团队创建,作为一款AI驱动的设计工具,专为设计师提供一站式增长服务。功能覆盖海量3D素材、AI绘画、实时渲染以及专业抠图,显著提升设计品质和效率。平台不仅提供工具,还是一个促进创意交流和个人发展的空间,界面友好,适合所有级别的设计师和创意工作者。

码上飞

零代码AI应用开发平台

零代码AI应用开发平台,用户只需一句话简单描述需求,AI能自动生成小程序、APP或H5网页应用,无需编写代码。

Vora

免费创建高清无水印Sora视频

Vora是一个免费创建高清无水印Sora视频的AI工具

Refly.AI

最适合小白的AI自动化工作流平台

无需编码,轻松生成可复用、可变现的AI自动化工作流

酷表ChatExcel

大模型驱动的Excel数据处理工具

基于大模型交互的表格处理系统,允许用户通过对话方式完成数据整理和可视化分析。系统采用机器学习算法解析用户指令,自动执行排序、公式计算和数据透视等操作,支持多种文件格式导入导出。数据处理响应速度保持在0.8秒以内,支持超过100万行数据的即时分析。

TRAE编程

AI辅助编程,代码自动修复

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

AIWritePaper论文写作

AI论文写作指导平台

AIWritePaper论文写作是一站式AI论文写作辅助工具,简化了选题、文献检索至论文撰写的整个过程。通过简单设定,平台可快速生成高质量论文大纲和全文,配合图表、参考文献等一应俱全,同时提供开题报告和答辩PPT等增值服务,保障数据安全,有效提升写作效率和论文质量。

博思AIPPT

AI一键生成PPT,就用博思AIPPT!

博思AIPPT,新一代的AI生成PPT平台,支持智能生成PPT、AI美化PPT、文本&链接生成PPT、导入Word/PDF/Markdown文档生成PPT等,内置海量精美PPT模板,涵盖商务、教育、科技等不同风格,同时针对每个页面提供多种版式,一键自适应切换,完美适配各种办公场景。

潮际好麦

AI赋能电商视觉革命,一站式智能商拍平台

潮际好麦深耕服装行业,是国内AI试衣效果最好的软件。使用先进AIGC能力为电商卖家批量提供优质的、低成本的商拍图。合作品牌有Shein、Lazada、安踏、百丽等65个国内外头部品牌,以及国内10万+淘宝、天猫、京东等主流平台的品牌商家,为卖家节省将近85%的出图成本,提升约3倍出图效率,让品牌能够快速上架。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号