StyleShot

多样化风格迁移的AI图像生成开源项目

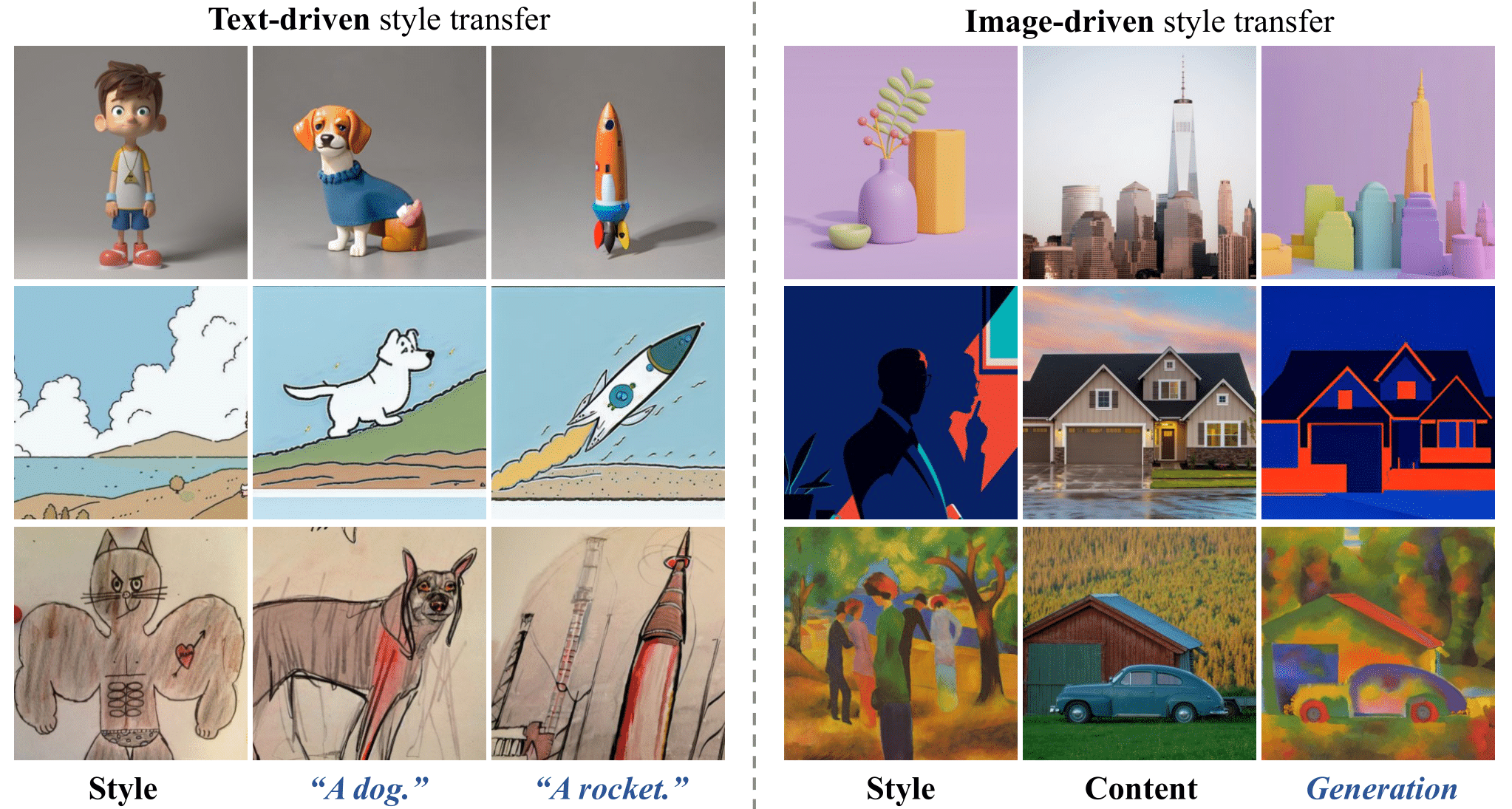

StyleShot是一个开源的AI图像生成项目,专注于实现广泛的风格迁移能力。通过风格感知编码器和StyleGallery数据集,它能够模仿3D、扁平、抽象等多种风格,无需测试时微调。项目在风格迁移性能上展现出优势,为图像风格化研究提供了新的方向和可能性。

StyleShot: 任意风格的快照

<div align="center"><a href='https://arxiv.org/abs/2407.01414'><img src='https://yellow-cdn.veclightyear.com/835a84d5/60f1081d-5467-428a-86ac-da30f895413b.svg'></a> <a href='https://styleshot.github.io/'><img src='https://img.shields.io/badge/Project-Page-Green'></a> <a href='https://openxlab.org.cn/apps/detail/lianchen/StyleShot'><img src='https://yellow-cdn.veclightyear.com/835a84d5/5165b426-3712-401b-9a33-e59fe6231bf0.svg'></a> <a href='https://huggingface.co/Gaojunyao/StyleShot'><img src='https://img.shields.io/badge/%F0%9F%A4%97%20Hugging%20Face-Model-blue'></a> <a target="_blank" href="https://huggingface.co/spaces/nowsyn/StyleShot"> <img src="https://yellow-cdn.veclightyear.com/835a84d5/29cd0853-7e2e-464d-9d8d-62a412d8e27f.svg" alt="Online Demo in HF"/> </a>

高俊尧, 刘彦辰, 孙亚楠<sup>‡</sup>, 唐寅豪, 曾艳红, 陈凯*, 赵彩荣* <br><br> (* 通讯作者, <sup>‡</sup> 项目负责人)

来自同济大学和上海人工智能实验室。

</div>摘要

在本文中,我们展示了一个好的风格表示对于无需测�试时调整的广义风格迁移至关重要且足够。我们通过构建一个风格感知编码器和一个组织良好的风格数据集StyleGallery来实现这一目标。通过专门设计用于风格学习,这个风格感知编码器经过解耦训练策略的训练,可以提取富有表现力的风格表示,而StyleGallery则赋予了泛化能力。我们还采用了一个内容融合编码器来增强图像驱动的风格迁移。我们强调,我们的方法StyleShot简单而有效,无需测试时调整即可模仿各种所需风格,如3D、平面、抽象甚至细粒度风格。严格的实验验证表明,与现有最先进的方法相比,StyleShot在广泛的风格范围内实现了卓越的性能。

新闻

- [2024/7/5] 🔥 我们在HuggingFace上发布了在线演示。

- [2024/7/3] 🔥 我们发布了StyleShot_lineart,这是一个以内容图像的线稿作为控制的版本。

- [2024/7/2] 🔥 我们发布了论文。

- [2024/7/1] 🔥 我们发布了代码、检查点、项目页面和在线演示。

开始使用

# 安装styleshot

git clone https://github.com/Jeoyal/StyleShot.git

cd StyleShot

# 创建conda环境

conda create -n styleshot python==3.8

conda activate styleshot

pip install -r requirements.txt

# 下载模型

git lfs install

git clone https://huggingface.co/Gaojunyao/StyleShot

git clone https://huggingface.co/Gaojunyao/StyleShot_lineart

模型

你可以从这��里下载我们的预训练权重。要运行演示,你还需要下载以下模型:

推理

对于推理,你应该下载预训练权重并准备自己的参考风格图像或内容图像。

# 运行文本驱动的风格迁移演示

python styleshot_text_driven_demo.py --style "{风格图像路径}" --prompt "{提示词}" --output "{保存路径}"

# 运行图像驱动的风格迁移演示

python styleshot_image_driven_demo.py --style "{风格图像路径}" --content "{内容图像路径}" --preprocessor "Contour" --prompt "{提示词}" --output "{保存路径}"

# 将styleshot与controlnet和t2i-adapter集成

python styleshot_t2i-adapter_demo.py --style "{风格图像路径}" --condition "{条件图像路径}" --prompt "{提示词}" --output "{保存路径}"

python styleshot_controlnet_demo.py --style "{风格图像路径}" --condition "{条件图像路径}" --prompt "{提示词}" --output "{保存路径}"

- styleshot_text_driven_demo:基于参考风格图像和文本提示的文本驱动风格迁移。

- styleshot_image_driven_demo:基于参考风格图像和内容图像的图像驱动风格迁移。

- styleshot_controlnet_demo,styleshot_t2i-adapter_demo:与controlnet和t2i-adapter的集成。

训练

我们采用两阶段训练策略来训练我们的StyleShot,以更好地融合内容和风格。对于训练数据,您可以使用我们的训练数据集StyleGallery或将自己的数据集制作成json文件。

# 训练阶段1,仅训练风格组件。

accelerate launch --num_processes 8 --multi_gpu --mixed_precision "fp16" \

tutorial_train_styleshot_stage_1.py \

--pretrained_model_name_or_path="runwayml/stable-diffusion-v1-5/" \

--image_encoder_path="{图像编码器路径}" \

--image_json_file="{data.json}" \

--image_root_path="{图像路径}" \

--mixed_precision="fp16" \

--resolution=512 \

--train_batch_size=16 \

--dataloader_num_workers=4 \

--learning_rate=1e-04 \

--weight_decay=0.01 \

--output_dir="{输出目录}" \

--save_steps=10000

# 训练阶段2,仅训练内容组件。

accelerate launch --num_processes 8 --multi_gpu --mixed_precision "fp16" \

tutorial_train_styleshot_stage_2.py \

--pretrained_model_name_or_path="runwayml/stable-diffusion-v1-5/" \

--pretrained_ip_adapter_path="./pretrained_weight/ip.bin" \

--pretrained_style_encoder_path="./pretrained_weight/style_aware_encoder.bin" \

--image_encoder_path="{图像编码器路径}" \

--image_json_file="{data.json}" \

--image_root_path="{图像路径}" \

--mixed_precision="fp16" \

--resolution=512 \

--train_batch_size=16 \

--dataloader_num_workers=4 \

--learning_rate=1e-04 \

--weight_decay=0.01 \

--output_dir="{输出目录}" \

--save_steps=10000

StyleGallery<a name="style_gallery"></a>

我们精心策划了一个风格平衡的数据集,称为StyleGallery,其中包含从公开可用数据集中提取的广泛多样的图像风格,用于训练我们的StyleShot。 要准备我们的数据集StyleGallery,请参考教程,或从这里下载json文件。

StyleBench

为解决基于参考的风格化生成缺乏基准的问题,我们建立了一个<a href='https://drive.google.com/file/d/1I-Zv5blsrJsckXrvcP_f8TJ4gy6xrwCA/view?usp=drive_link'>风格评估基准</a>,包含490个参考图像中的73种不同风格。

免责声明

我们开发此仓库用于研究目的,因此它只能用于个人/研究/非商业用途。

引用

如果您发现StyleShot对您的研究和应用有用,请使用以下BibTeX进行引用:

@article{gao2024styleshot, title={StyleShot: A Snapshot on Any Style}, author={Junyao, Gao and Yanchen, Liu and Yanan, Sun and Yinhao, Tang and Yanhong, Zeng and Kai, Chen and Cairong, Zhao}, booktitle={arXiv preprint arxiv:2407.01414}, year={2024} }

致谢

该代码基于<a href='https://github.com/tencent-ailab/IP-Adapter'>IP-Adapter</a>构建。

编辑推荐精选

扣子-AI办公

职场AI,就用扣子

AI办公助手,复杂任务高效处理。办公效率低?扣子空间AI助手支持播客生成、PPT制作、网页开发及报告写作,覆盖科研、商业、舆情等领域的专家Agent 7x24小时响应,生活工作无缝切换,提升50%效率!

堆友

多风格AI绘画神器

堆友平台由阿里巴巴设计团队创建,作为一款AI驱动的设计工具,专为设计师提供一站式增长服务。功能覆盖海量3D素材、AI绘画、实时渲染以及专业抠图,显著提升设计品质和效率。平台不仅提供工具,还是一个促进创意交流和个人发展的空间,界面友好,适合所有级别的设计师和创意工作者。

码上飞

零代码AI应用开发平台

零代码AI应用开发平台,用户只需一句话简单描述需求,AI能自动生成小程序、APP或H5网页应用,无需编写代码。

Vora

免费创建高清无水印Sora视频

Vora是一个免费创建高清无水印Sora视频的AI工具

Refly.AI

最适合小白的AI自动化工作流平台

无需编码,轻松生成可复用、可变现的AI自动化工作流

酷表ChatExcel

大模型驱动的Excel数据处理工具

基于大模型交互的表格处理系统,允许用户通过对话方式完成数据整理和可视化分析。系统采用机器学习算法解析用户指令,自动执行排序、公式计算和数据透视等操作,支持多种文件格式导入导出。数据处理响应速度保持在0.8秒以内,支持超过100万行数据的即时分析。

TRAE编程

AI辅助编程,代码自动修复

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动�完成功能,是提升开发效率的理想工具。

AIWritePaper论文写作

AI论文写作指导平台

AIWritePaper论文写作是一站式AI论文写作辅助工具,简��化了选题、文献检索至论文撰写的整个过程。通过简单设定,平台可快速生成高质量论文大纲和全文,配合图表、参考文献等一应俱全,同时提供开题报告和答辩PPT等增值服务,保障数据安全,有效提升写作效率和论文质量。

博思AIPPT

AI一键生成PPT,就用博思AIPPT!

博思AIPPT,新一代的AI生成PPT平台,支持智能生成PPT、AI美化PPT、文本&链接生成PPT、导入Word/PDF/Markdown文档生成PPT等,内置海量精美PPT模板,涵盖商务、教育、科技等不同风格,同时针对每个页面提供多种版式,一键自适应切换,完美适配各种办公场景。

潮际好麦

AI赋能电商视觉革命,一站式智能商拍平台

潮际好麦深耕服装行业,是国内AI试衣效果最好的软件。使用先进AIGC能力为电商卖家批量提供优质的、低成本的商拍图。合作品牌有Shein、Lazada、安踏、百丽等65个国内外头部品牌,以及国内10万+淘宝、天猫、京东等主流平台的品牌商家,为卖家节省将近85%的出图成本,提升约3倍出图效率,让品牌能够快速上架。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号