Continuous-Eval: 数据驱动的LLM应用评估框架

Continuous-Eval: 为LLM应用提供全面评估的开源框架

在人工智能和大语言模型(LLM)快速发展的今天,如何有效评估和优化LLM驱动的应用成为了一个重要课题。Continuous-Eval应运而生,它是一个专为LLM应用设计的开源评估框架,旨在通过数据驱动的方法为开发者提供全面、精准的评估工具。本文将深入介绍Continuous-Eval的核心特性、使用方法以及它如何助力LLM应用的持续优化。

Continuous-Eval的核心特性

1. 模块化评估

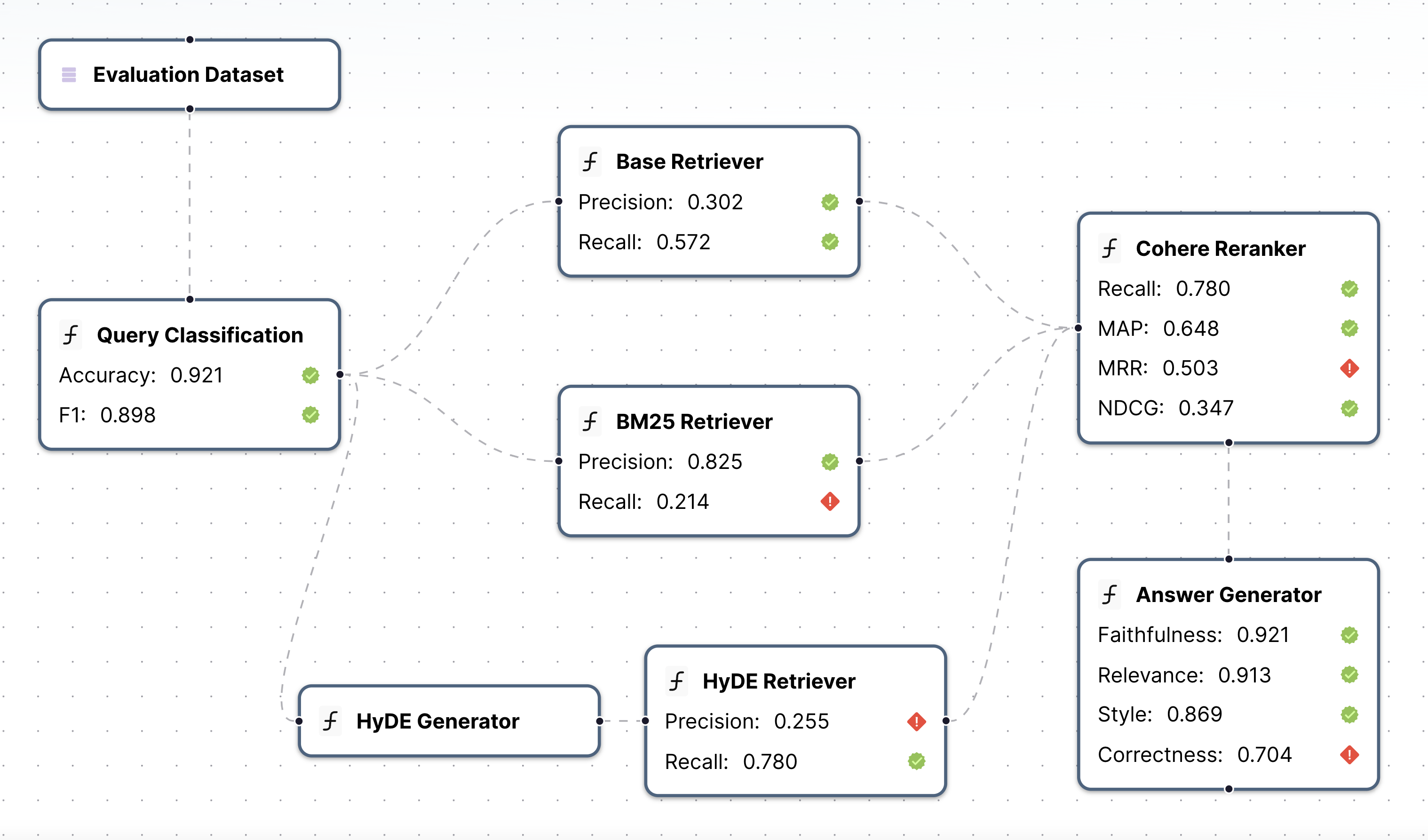

Continuous-Eval的一大亮点是其模块化评估能力。它允许开发者对应用pipeline中的每个模块进行单独评估,使用针对性的指标。这种细粒度的评估方法使得开发者能够精确定位应用中的瓶颈或问题区域,从而进行有针对性的优化。

如上图所示,Continuous-Eval支持对检索、重排序、生成等多个环节进行独立评估,每个环节都可以应用特定的评估指标。

2. 全面的指标库

Continuous-Eval提供了一个全面的评估指标库,涵盖了多种LLM应用场景:

- 检索增强生成(RAG)

- 代码生成

- 智能体工具使用

- 分类任务

- 其他LLM使用场景

这些指标包括确定性指标、语义指标和基于LLM的指标,开发者可以根据需求灵活组合使用。例如,对于RAG系统,可以同时使用精确率、召回率、F1值等传统指标,以及基于LLM的上下文精确度和覆盖率指标,全方位评估系统性能。

3. 整合用户反馈

Continuous-Eval创新性地引入了用户反馈整合机制。开发者可以轻松构建一个接近人类评判的集成评估流程,并且具有数学保证。这一特性使得评估结果更贴近实际应用场景,提高了评估的可靠性和实用性。

4. 合�成数据集生成

为解决高质量评估数据集稀缺的问题,Continuous-Eval提供了合成数据集生成功能。开发者可以生成大规模的合成数据集来测试其应用pipeline,这不仅节省了人工标注的时间和成本,还能覆盖更多的边缘情况,提高评估的全面性。

快速上手Continuous-Eval

Continuous-Eval的使用非常简单直观。首先,通过pip安装包:

python3 -m pip install continuous-eval

然后,你就可以开始使用各种评估指标了。以下是一个简单的例子,展示如何使用精确率、召回率和F1值来评估检索结果:

from continuous_eval.metrics.retrieval import PrecisionRecallF1 datum = { "question": "What is the capital of France?", "retrieved_context": [ "Paris is the capital of France and its largest city.", "Lyon is a major city in France.", ], "ground_truth_context": ["Paris is the capital of France."], "answer": "Paris", "ground_truths": ["Paris"], } metric = PrecisionRecallF1() print(metric(**datum))

评估完整的应用Pipeline

Continuous-Eval的强大之处在于它能够评估整个应用pipeline。你可以定义pipeline中的各个模块,并为每个模块选择相应的评估指标:

from continuous_eval.eval import Module, ModuleOutput, Pipeline, Dataset, EvaluationRunner from continuous_eval.eval.logger import PipelineLogger from continuous_eval.metrics.retrieval import PrecisionRecallF1, RankedRetrievalMetrics from continuous_eval.metrics.generation.text import DeterministicAnswerCorrectness dataset = Dataset("dataset_folder") # 定义一个简单的3步RAG pipeline: Retriever -> Reranker -> Generation retriever = Module( name="Retriever", input=dataset.question, output=List[str], eval=[ PrecisionRecallF1().use( retrieved_context=ModuleOutput(), ground_truth_context=dataset.ground_truth_context, ), ], ) reranker = Module( name="reranker", input=retriever, output=List[Dict[str, str]], eval=[ RankedRetrievalMetrics().use( retrieved_context=ModuleOutput(), ground_truth_context=dataset.ground_truth_context, ), ], ) llm = Module( name="answer_generator", input=reranker, output=str, eval=[ DeterministicAnswerCorrectness().use( answer=ModuleOutput(), ground_truth_answers=dataset.ground_truths ), ], ) pipeline = Pipeline([retriever, reranker, llm], dataset=dataset)

定义好pipeline后,你可以使用EvaluationRunner来运行评估:

evalrunner = EvaluationRunner(pipeline) metrics = evalrunner.evaluate(dataset) print(metrics.results()) # 输出评估结果

合成数据生成

Continuous-Eval还提供了强大的合成数据生成功能。通过Relari平台,你可以生成定制的合成数据集,用于评估或训练。这些数据集可以模拟各种用户交互场景,如RAG系统、智能体、代码助手等,为你的评估提供更丰富的测试数据。

开源社区与贡献

Continuous-Eval是一个开源项目,欢迎社区贡献。如果你有兴趣参与项目开发,可以查看贡献指南了解更多详情。项目使用Apache 2.0许可证,鼓励自由使用和分发。

结语

Continuous-Eval为LLM应用开发者提供了一个强大而灵活的评估框架。通过模块化评估、全面的指标库、用户反馈整合和合成数据生成,它使得LLM应用的评估和优化变得更加简单和高效。无论你是在开发RAG系统、智能体还是其他类型的LLM应用,Continuous-Eval都能为你提供宝贵的洞察和改进方向。

随着LLM技术的不断发展,像Continuous-Eval这样的评估工具将在确保AI应用质量和可靠性方面发挥越来越重要的作用。我们期待看到更多开发者利用这个强大的工具,推动LLM应用向更高水平发展。

🔗 相关资源:

通过Continuous-Eval,让我们共同推动LLM应用评估的边界,为用户带来更优质、更可靠的AI体验! 🚀

编辑推荐精选

Vora

免费创建高清无水印Sora视频

Vora是一个免费创建高清无水印Sora视频的AI工具

Refly.AI

最适合小白的AI自动化工作流平台

无需编码,轻松生成可复用、可变现的AI自动化工作流

酷表ChatExcel

大模型驱动的Excel数据处理工具

基于大模型交互的表格处理系统,允许用户通过对话方式完成数据整理和可视化�分析。系统采用机器学习算法解析用户指令,自动执行排序、公式计算和数据透视等操作,支持多种文件格式导入导出。数据处理响应速度保持在0.8秒以内,支持超过100万行数据的即时分析。

TRAE编程

AI辅助编程,代码自动修复

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

AIWritePaper论文写作

AI论文写作指导平台

AIWritePaper论文写作是一站式AI论文写作辅助工具,简化了选题、文献检索至论文撰写的整个过程。通过简单设定,平台可快速生成高质量论文大纲和全文,配合图表、参考文献等一应俱全,同时提供开题报告和答辩PPT等增值服务,保障数据安全,有效提升写作效率和论文质量。

博思AIPPT

AI一键生成PPT,就用博思AIPPT!

博思AIPPT,新一代的AI生成PPT平台,支持智能生成PPT、AI美化PPT、文本&链接生成PPT、导入Word/PDF/Markdown文档生成PPT等,内置海量精美PPT模板,涵盖商务、教育、科技等不同风格,同时针对每个页面提供多种版式,一键自适应切换,完美适配各种办公场景。

潮际好麦

AI赋能电商视觉革命,一站式智能商拍平台

潮际好麦深耕服装行业,是国内AI试衣效果最好的软件。使用先进AIGC能力为电商卖家批量提供优质的、低成本的商拍图。合作品牌有Shein、Lazada、安踏、百丽等65个国内外头部品牌,以及国内10万+淘宝、天猫、京东等主流平台的品牌商家,为卖家节省将近85%的出图成本,提升约3倍出图效率,让品牌能够快速上架。

iTerms

企业专属的AI法律顾问

iTerms是法大大集团旗下法律子品牌,基于最先进的大语言模型(LLM)、专业的法律知识库和强大的智能体架构,帮助企业扫清合规障碍,筑牢风控防线,成为您企业专属的AI法律顾问。

SimilarWeb流量提升

稳定高效的流量提升解决方案,助力��品牌曝光

稳定高效的流量提升解决方案,助力品牌曝光

Sora2视频免费生成

最新版Sora2模型免费使用,一键生成无水印视频

最新版Sora2模型免费使用,一键生成无水印视频

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号