VisCPM

基于CPM-Bee的多模态大模型 对话和图像生成

VisCPM是基于CPM-Bee语言模型开发的开源多模态大模型系列,包含VisCPM-Chat和VisCPM-Paint两个模型。VisCPM-Chat支持中英双语多模态对话,VisCPM-Paint实现文到图生成。该项目仅通过英文数据预训练即实现了出色的中文多模态能力,在中文开源多模态模型中表现优异。VisCPM开源供个人和研究使用,旨在促进多模态大模型领域进步。

VisCPM

基于CPM基础模型的中英双语多模态大模型系列

<p align="center"> <a href="#-viscpm-chat">多模态对话模型VisCPM-Chat</a> • <a href="#-viscpm-paint">文生图模型VisCPM-Paint</a> • <a href="#-使用">使用</a> • <a href="https://arxiv.org/pdf/2308.12038.pdf">论文</a> </p> <p> <a href="http://120.92.209.146/">VisCPM-Chat Demo</a> • <a href="https://huggingface.co/spaces/openbmb/viscpm-paint">VisCPM-Paint Demo</a> • <a href="https://huggingface.co/openbmb/VisCPM-Chat"> VisCPM-Chat🤗 </a> • <a href="https://huggingface.co/openbmb/VisCPM-Paint"> VisCPM-Paint🤗 </a> </p> <p align="center"> 简体中文 | <a href="README_en.md">English</a> </p> </div>**VisCPM**是一个开源的多模态大模型系列,支持中英双语的多模态对话能力(VisCPM-Chat模型)和文到图生成能力(VisCPM-Paint模型),在中文多模态开源模型中达到最佳水平。VisCPM基于百亿参数量语言大模型CPM-Bee(10B)训练,融合视觉编码器Muffin和视觉解码器Diffusion-UNet以支持视觉信号的输入和输出。得益于CPM-Bee基座优秀的双语能力,VisCPM可以仅通过英文多模态数据预训练,泛化实现优秀的中文多模态能力。

- 👐 开源使用:VisCPM可以自由被用于个人和研究用途。我们希望通过开源VisCPM模型系列,推动多模态大模型开源社区和相关研究的发展。

- 🌟 涵盖图文双向生成:VisCPM模型系列较为全面地支持了图文多模态能力,涵盖多模态对话(图到文生成)能力和文到图生成能力。

- 💫 中英双语性能优异:得益于语言模型基座CPM-Bee优秀的双语能力,VisCPM在中英双语的多模态对话和文到图生成均取得亮眼的效果。

📰 更新信息

VisCPM在持续升级中,我们支持了低资源推理、网页版部署等功能,并提供了能力升级的更高版本的模型OmniLMM,欢迎大家持续关注!

- [2024/04/17] 🚀 欢迎关注我们最新发布的MiniCPM-V 2.0端侧多模态大模型,具备领先的光学字符识别(OCR)和多模态理解能力,在综合性OCR能力评测基准OCRBench上达到开源模型最佳水平,甚至在场景文字理解方面实现接近Gemini Pro的性能。

- [2024/02/02] 🚀 欢迎关注我们最新发布的OmniLMM多模态大模型!其中OmniLMM-3B为中英双语多模态对话模型,基于中英双语大模型MiniCPM-2.4B和SigLip-400M视觉编码器训练,采用与VisCPM-Chat相同的训练流程训练,可在终端设备上部署并具备先进的多模态对话能力;OmniLMM-13B为英文多模态模型,基于EVA02-5B和Zephyr-7B-β初始化训练,相比同规模其他模型在多个基准测试中具有领先性能。

- [2024/01/16] 🎉 VisCPM论文被ICLR 2024接收,并被选为spotlight(top 5%)!

- [2023/09/06] 🔌 VisCPM-Chat API 发布!现在您可以直接通过API轻松地使用VisCPM-Chat模型了。查看API使用指南以了解更多详情。

- [2023/08/23] 📑 VisCPM论文发布:Large Multilingual Models Pivot Zero-Shot Multimodal Learning across Languages,论文提供了更详细的实现细节和实验结果

- [2023/08/18] ⤴️ VisCPM-Chat-v1.1版本发布,带来更强的细节理解和复杂推理能力!

- [2023/08/18] 🛠️ 支持微调,让VisCPM更适配你的应用场景!

- [2023/07/20] 🌐 发布VisCPM-Chat和VisCPM-Paint 的在线Demo,欢迎尝试!

- [2023/07/20] 🎢 支持一键部署本地网页版Demo

- [2023/07/20] ⚡️ 支持低资源推理,最低5G显存运行多模态对话模型!

- [2023/07/18] 🤗 VisCPM-Chat和VisCPM-Paint 已整合到Huggingface框架中

<img src="https://yellow-cdn.veclightyear.com/835a84d5/d98f455b-6b2d-42da-96f7-c8771a4a208b.png" width="28px" /> VisCPM-Chat

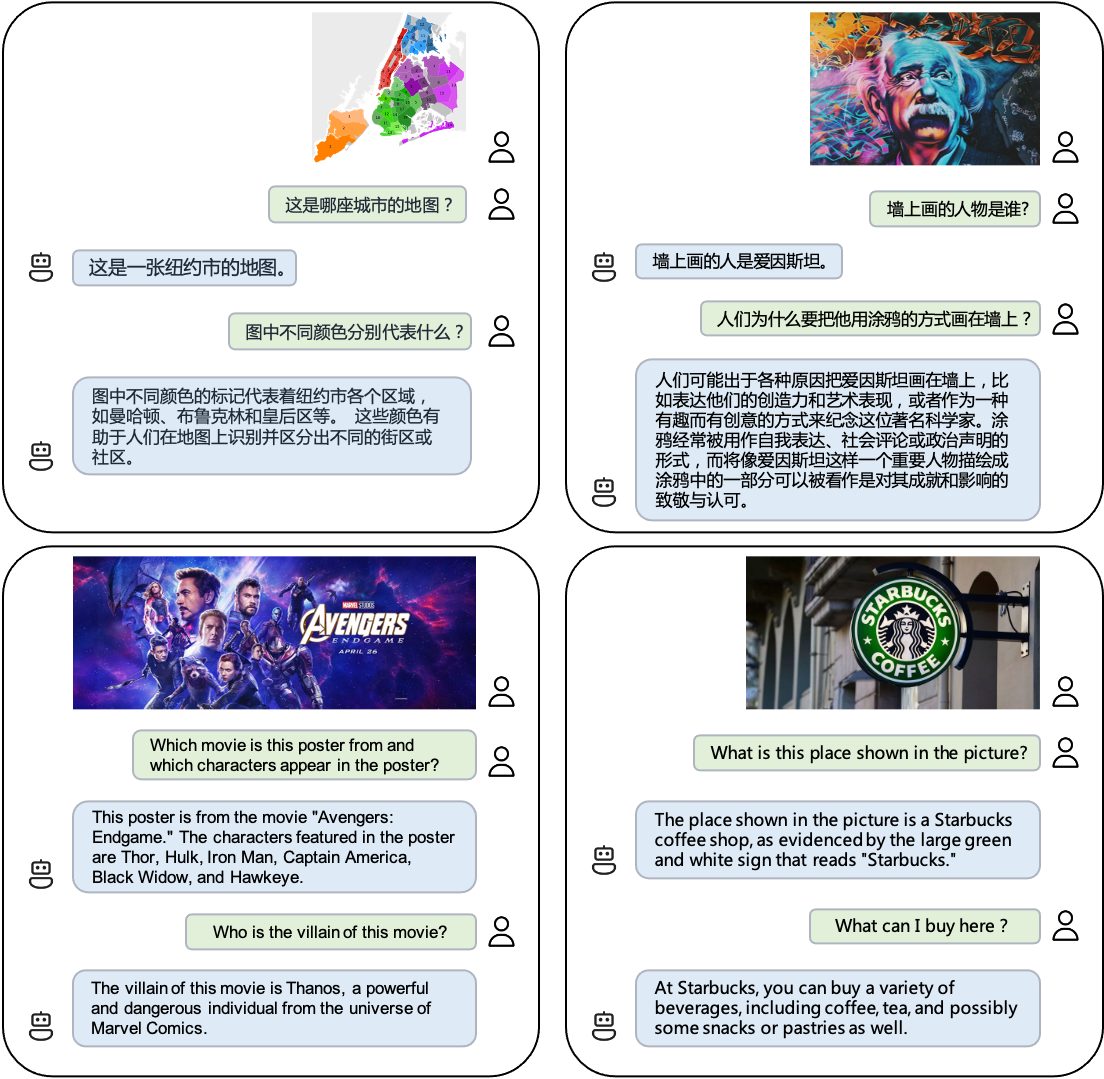

VisCPM-Chat支持面向图像进行中英双语多模态对话。该模型使用Muffin视觉编码架构,使用CPM-Bee(10B)作为语言基座模型,并通过语言建模训练目标融合视觉和语言模型。模型训练包括预训练和指令精调两阶段:

-

预训练:我们使用了约1亿对高质量英文图文数据对

VisCPM-Chat进行预训练,数据来源包括CC3M、CC12M、COCO、Visual Genome和Laion等。在预训练阶段,我们保持语言模型参数不变,仅更新视觉编码器的参数,以实现大规模视觉-语言表示的高效对齐。 -

指令精调:我们采用LLaVA-150K英文指令精调数据,并结合相应的中文翻译数据对模型进行指令精调,以使模型的多模态基础能力与用户使用意图相匹配。在指令精调阶段,我们更新全部模型参数,以提高指令精调数据的利用效率。有趣的是,我们发现即使仅使用英文指令数据进行精调,模型也能理解中文问题,但只能用英文回答。这表明模型的多语言多模态能力已经得到了良好的泛化。在指令精调阶段进一步加入少量中文翻译数据,可以使模型的回复语言与用户提问语言保持一致。

我们在LLaVA标准英文测试集和翻译的中文测试集上对模型进行了评测。这个评测基准考察了模型在开放域对话、图像细节描述和复杂推理方面的表现,并使用GPT-4进行打分。结果显示,VisCPM-Chat在中文多模态能力方面取得了最佳的平均性能,在通用域对话和复杂推理方面表现出色,同时也展现出了不错的英文多模态能力。我们提供了两个模型版本,分别是VisCPM-Chat-balance和VisCPM-Chat-zhplus。前者在英文和中文两种语言上的能力较为平衡,后者在中文能力上更为突出。两个模型在指令精调阶段使用的数据相同,但VisCPM-Chat-zhplus在预训练阶段额外加入了2000万对经过清洗的原生中文图文数据和1.2亿对翻译成中文的图文数据。VisCPM-Chat-v1.1在指令精调阶段还额外加入了UniMM-Chat多模态指令精调数据集。

<img src="https://yellow-cdn.veclightyear.com/835a84d5/3db8e524-56c0-4c36-98fa-e1966ed988e4.png" height="28px" /> VisCPM-Paint

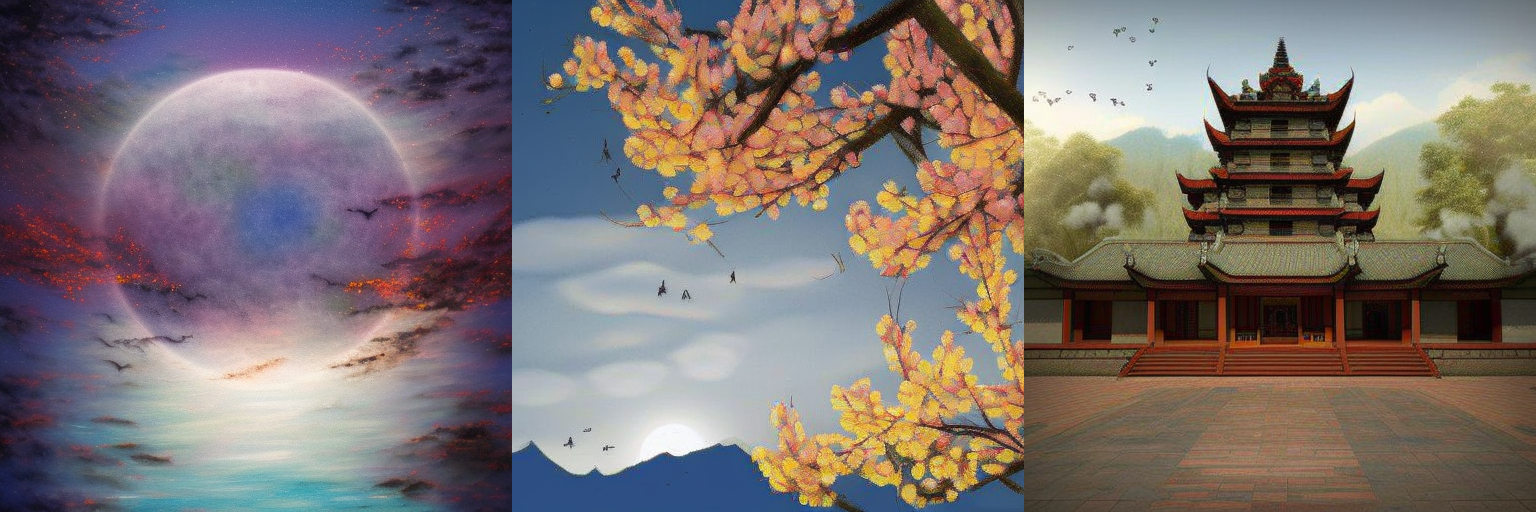

VisCPM-Paint支持中英双语的文本到图像生成。该模型使用CPM-Bee(10B)作为文本编码器,使用UNet作为图像解码器,并通过扩散模型训练目标融合语言和视觉模型。在训练过程中,语言模型参数始终保持固定。我们使用Stable Diffusion 2.1的UNet参数初始化视觉解码器,并通过逐步解冻其中关键的桥接参数将其与语言模型融合。该模型在LAION 2B英文图文对数据上进行了训练。

与VisCPM-Chat类似,我们发现得益于CPM-Bee的双语能力,VisCPM-Paint仅通过英文图文对训练就能泛化实现良好的中文文到图生成能力,达到中文开源模型的最佳效果。通过进一步加入20M经过清洗的原生中文图文对数据,以及120M翻译成中文的图文对数据,模型的中文文到图生成能力可以获得进一步提升。我们在标准图像生成测试集MSCOCO上采样了3万张图片,计算了常用评估图像生成指标FID (Fréchet Inception Distance)来评估生成图片的质量。我们同样提供了两个模型版本,分别为VisCPM-Paint-balance和VisCPM-Paint-zhplus,前者在英文和中文两种语言上的能力较为平衡,后者在中文能力上更加突出。VisCPM-Paint-balance只使用了英文图文对进行训练,VisCPM-Paint-zhplus在VisCPM-Paint-balance基础上增加了20M原生中文图文对数据和120M翻译成中文的图文对数据进行训练。

⚙️ 安装

- 克隆仓库并进入源码目录

git clone https://github.com/OpenBMB/VisCPM.git cd VisCPM

- 创建conda环境

conda create -n viscpm python=3.10 -y conda activate viscpm

- 安装依赖

pip install torch>=1.10 pip install -r requirements.txt

💡 使用

模型下载

| 模型 | 描述 | 下载链接 |

|---|---|---|

| VisCPM-Chat-v1.1 | 新版本多模态对话模型,强化了细节理解和复杂推理能力 | 链接 |

| VisCPM-Chat-balance | 中英文能力较为平衡的多模态对话模型 | 链接 |

| VisCPM-Chat-zhplus | 中文能力突出的多模态对话模型 | 链接 |

| VisCPM-Paint-balance | 中英文能力较为平衡的文生图模型 | 链接 |

| VisCPM-Paint-zhplus | 中文能力突出的文生图模型 | 链接 |

VisCPM-Chat

在下载模型权重后,可以使用如下代码运行VisCPM-Chat(将'/path/to/checkpoint'改为模型存放路径)

单轮对话

<div align="center"> <img src="https://yellow-cdn.veclightyear.com/835a84d5/084bef76-2b17-4252-b46f-361708da5ff5.png" width="660px"> </div>VisCPM-Chat可以通过几行代码实现多模态对话,我们在代码中默认开启了对输入图片的安全检查。

# 如果您单卡显存不足40G,可以引入如下环境变量并将安全模块开关关闭。引入后显存占用约为5G,但推理所需时间会变长。此选项依赖BMInf,需要安装BMInf依赖库。 export CUDA_MEMORY_CPMBEE_MAX=1g

from VisCPM import VisCPMChat from PIL import Image model_path = '/path/to/checkpoint' viscpm_chat = VisCPMChat(model_path, image_safety_checker=True) # 默认开启对输入图片的安全检查 image_path = 'figures/vlu_case1.png' image = Image.open(image_path).convert("RGB") question = '如果用一句中国唐代的著名诗人"李白"的古诗来描述这幅图像,你能想到��什么?' answer, _, _ = viscpm_chat.chat(image, question) print(answer)

可得到如下结果

"黄河之水天上来,奔流到海不复回。" 李白的这句诗可以用来形容这幅图片中汹涌澎湃、波涛汹涌的景象:一条湍急的河流从山上奔腾而下,形成了一幅令人叹为观止的画面,展示出大自然的力量和雄伟壮丽。

多轮对话

<div align="center"> <img src="https://yellow-cdn.veclightyear.com/835a84d5/7ece87a2-1544-487c-9f76-dff5b1c5d008.jpeg" width="660px"> </div>from VisCPM import VisCPMChat from PIL import Image model_path = '/path/to/checkpoint' viscpm_chat = VisCPMChat(model_path, image_safety_checker=True) # 默认开启对输入图片的安全检查 image_path = 'figures/vlu_case2.jpeg' image = Image.open(image_path).convert("RGB") question = '这幅图像是在哪个节日拍摄的?' answer, context, vision_hidden_states = viscpm_chat.chat(image, question) # 多轮对话传入历史 context question = '你能用什么古诗描述这幅画?' answer, context, _ = viscpm_chat.chat(image, question, context, vision_hidden_states=vision_hidden_states) print(context)

可得到如下结果

User: 这幅图像是在哪个节日拍摄的?

AI: 这幅图像是在中秋节拍摄的, 也就是中国传统节日中的月圆之夜。

User: 你能用什么古诗描述这幅画?

AI: "明月几时有,把酒问青天。" 这是苏轼的《水调歌头》中的一句诗,用来形容这幅图片再贴切不过了:在中秋之夜,月亮高高地挂在天空中,一座古老的建筑沐浴着月光,营造出一种宁静祥和的气氛。

API使用指南

我们提供了API接口,可以通过如下代码轻松体验VisCPM-Chat。API接口支持的输入格式和使用方式如下:

import requests import base64 url = "http://34.143.180.202:3389/viscpm" resp = requests.post(url, json={ # 需要修改 "image": base64.b64encode(open("path/to/image", "rb").read()).decode(), "question": "描述一下这张图片", }) resp = resp.json() print(resp)

VisCPM-Paint

在下载模型权重后,可以使用如下代码运行VisCPM-Paint(将'/path/to/checkpoint'改为模型存放路径)。

生成上面图片的文本输入可参考prompts.txt。

# 如果您单卡显存不足40G,可以引入如下环境变量并将安全模块开关关闭。引入后显存占用约为17G,但推理所需时间会变长。此选项依赖BMInf,需要安装BMInf依赖库。 export CUDA_MEMORY_CPMBEE_MAX=1g

from VisCPM import VisCPMPaint painter = VisCPMPaint('/path/to/checkpoint', image_safety_checker=True, prompt_safety_checker=True, add_ranker=True) # 默认对输入的文本和输出的图片进行安全检查,默认开启重排序 image = painter.generate('人闲桂花落,月静春山空') # 对应上图第一行第二张图片 image.save('/data/test.png')

我们在代码中默认开启了对输入文本和输出图片的安全检查。

同时,我们默认对生成的图像使用重排序,即对同一个输入,同时生成4张图片,返回与输入相关性最高的1张图片,相关性通过Chinese-Clip进行打分。重排序可以提升生成图片质量的稳定性,但也会降低模型的生成速度,如希望快速得到生成结果,可以关闭重排序机制。

VisCPM-Paint目前使用中文模型进行重排序打分,如果输入英文生成图片,请关闭重排序机制和输入文本检查模块。

低资源推理

为了支持更加高效的低资源推理场景,我们借助BMInf工具支持更低的显存需求。首先安装BMInf依赖pip install bminf,然后在命令行中指定export CUDA_MEMORY_CPMBEE_MAX=1g(具体数值可以根据个人需求设定),然后按照上述步骤进行推理,VisCPM-Chat最低显存占用可以降至5G,VisCPM-Paint最低显存占用可以降至17G。

Demo部署

我们提供简易的基于gradio的网页版Demo,首先安装gradio:pip install gradio,然后执行如下命令:

git clone https://github.com/OpenBMB/VisCPM.git cd VisCPM python demo_chat.py # viscpm_chat demo, 或者 python demo_paint.py # viscpm_paint demo

模型微调

为适应特定场景下的需求, 我们提供了VisCPM-Chat模型的微调代码,用户可以在私有数据上进行微调。微调代码位于./finetune/ft_viscpm_chat目录下,具体的微调代码使用方法如下:

# 获取数据集 bash ./finetune/ft_viscpm_chat/get_llava150k_zh.sh # 模型微调, 注意修改其中的数据集与模型checkpoint路径 bash ./finetune/ft_viscpm_chat/run_viscpm_chat_ft.sh # node: 8 # batch_size: 8 * 1 # 其他配置可参考'./finetune/ft_viscpm_chat/config/viscpm_chat_ft.json'与'./finetune/ft_viscpm_chat/run_viscpm_chat_ft.sh'

注:

- 微调代码中使用了deepspeed-0.9.1配置训练环境,配置方法可以参考此链接。

- 目前微调代码仅在linux系统下测试,如果您在其他系统配置下进行微调,可能需要修改部分代码。

🛡 安全

安全声明

作为多模态模型,VisCPM通过学习大量的公开图文数据来生成内容,但它无法理解、表达个人观点或价值判断,它所输出的任何内容都不�代表模型开发者的观点和立场。因此用户在使用VisCPM生成的内容时,应自行负责对其进行评估和验证。

安全模块

为了帮助用户防止模型处理或生成不符合普遍社会价值观的内容,我们在VisCPM中加入了内容安全保障模块。当安全模块检测到模型处理或生成的图像文本内容不符合安全规范时,会对相应内容进行拦截。我们对VisCPM-Chat接受的图片输入以及VisCPM-Paint接受的文字输入和图片输出进行了安全检查。VisCPM的安全模块仍然不完美,可能会出现漏判和误判的情况。我们会在未来进一步提升安全模块的性能。

📝 开源协议

VisCPM系列模型采用协议为"通用模型许可协议-来源说明-宣传限制-非商业化",允许个人使用和研究用途。如需将模型用于商业用途,请联系cpm@modelbest.cn来洽谈商业授权事宜。

CPM-Bee基座采用协议为"通用模型许可协议-来源说明-宣传限制-商业授权",允许商用,如需将模型用于商业用途,请联系cpm@modelbest.cn来获取书面授权。

✅ 待办事项

- 支持模型量化功能,降低推理成本

🏫 机构

此项目由以下机构联合研发:

- <img src="https://yellow-cdn.veclightyear.com/835a84d5/4a3590a1-da49-41a3-a20d-aef9bd33dd14.png" width="28px"> 清华自然语言处理实验室

- <img src="https://yellow-cdn.veclightyear.com/835a84d5/3ff28ce3-89ca-4c33-afe6-2a372cbc7739.png" width="28px"> 面壁智能

- <img src="https://yellow-cdn.veclightyear.com/835a84d5/62ec750f-ea96-40c1-95a8-213e58a897c0.webp" width="28px"> 知乎

引用

如果我们的工作对你有帮助,请考虑引用以下论文

@article{VisCPM, title={Large multilingual models pivot zero-shot multimodal learning across languages}, author={Hu, Jinyi and Yao, Yuan and Wang, Chongyi and Wang, Shan and Pan, Yinxu and Chen, Qianyu and Yu, Tianyu and Wu, Hanghao and Zhao, Yue and Zhang, Haoye and others}, journal={arXiv preprint arXiv:2308.12038}, year={2023} } @article{muffin, title={Reformulating vision-language foundation models and datasets towards universal multimodal assistants}, author={Yu, Tianyu and Hu, Jinyi and Yao, Yuan and Zhang, Haoye and Zhao, Yue and Wang, Chongyi and Wang, Shan and Pan, Yinxv and Xue, Jiao and Li, Dahai and others}, journal={arXiv preprint arXiv:2310.00653}, year={2023} }

编辑推荐精选

扣子-AI办公

职场AI,就用扣子

AI办公助手,复杂任务高效处��理。办公效率低?扣子空间AI助手支持播客生成、PPT制作、网页开发及报告写作,覆盖科研、商业、舆情等领域的专家Agent 7x24小时响应,生活工作无缝切换,提升50%效率!

堆友

多风格AI绘画神器

堆友平台由阿里巴巴设计团队创建,作为一款AI驱动的设计工具,专为设计师提供一站式增长服务。功能覆盖海量3D素材、AI绘画、实时渲染以及专业抠图,显著提升设计品质和效率。平台不仅提供工具,还是一个促进创意交流和个人发展的空间,界面友好,适合所有级别的设计师和创意工作者。

码上飞

零代码AI应用开发平台

零代码AI应用开发平台,用户只需一句话简单描述需求,AI能自动生成小程序、APP或H5网页应用,无需编写代码。

Vora

免费创建高清无水印Sora视频

Vora是一个免费创建高清无水印Sora视频的AI工具

Refly.AI

最适合小白的AI自动化工作流平台

无需编码,轻松生成可复用、可变现的AI自动化工作流

酷表ChatExcel

大模型驱动的Excel数据处理工具

基于大模型交互的表格处理系统,允许用户通过对话方式完成数据整理和可视化分析。系统采用机器学习算法解析用户指令,自动执行排序、公式计算和数据透视等操作,支持多种文件格式导入导出。数据处理响应速度保持在0.8秒以内,支持超过100万行数据的即时分析。

TRAE编程

AI辅助编程,代码自动修复

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是�提升开发效率的理想工具。

AIWritePaper论文写作

AI论文写作指导平台

AIWritePaper论文写作是一站式AI论文写作辅助工具,简化了选题、文��献检索至论文撰写的整个过程。通过简单设定,平台可快速生成高质量论文大纲和全文,配合图表、参考文献等一应俱全,同时提供开题报告和答辩PPT等增值服务,保障数据安全,有效提升写作效率和论文质量。

博思AIPPT

AI一键生成PPT,就用博思AIPPT!

博思AIPPT,新一代的AI生成PPT平台,支持智能生成PPT、AI美化PPT、文本&链接生成PPT、导入Word/PDF/Markdown文档生成PPT等,内置海量精美PPT模板,涵盖商务、教育、科技等不同风格,同时针对每个页面提供多种版式,一键自适应切换,完美适配各种办公场景。

潮际好麦

AI赋能电商视觉革命,一站式智能商拍平台

潮际好麦深耕服装行业,是国内AI试衣效果最好的软件。使用先进AIGC能力为电商卖家批量提供优质的、低成本的商拍图。合作品牌有Shein、Lazada、安踏、百丽等65个国内外头部品牌,以及国内10万+淘宝、天猫、京东等主流平台的品牌商家,为卖家节省将近85%的出图成本,提升约3倍出图效率,让品牌能够快速上架。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号